温馨提示:本文最后更新于

2024-11-28 16:58:34,某些文章具有时效性,若有错误或已失效,请在下方留言。安装 ollama

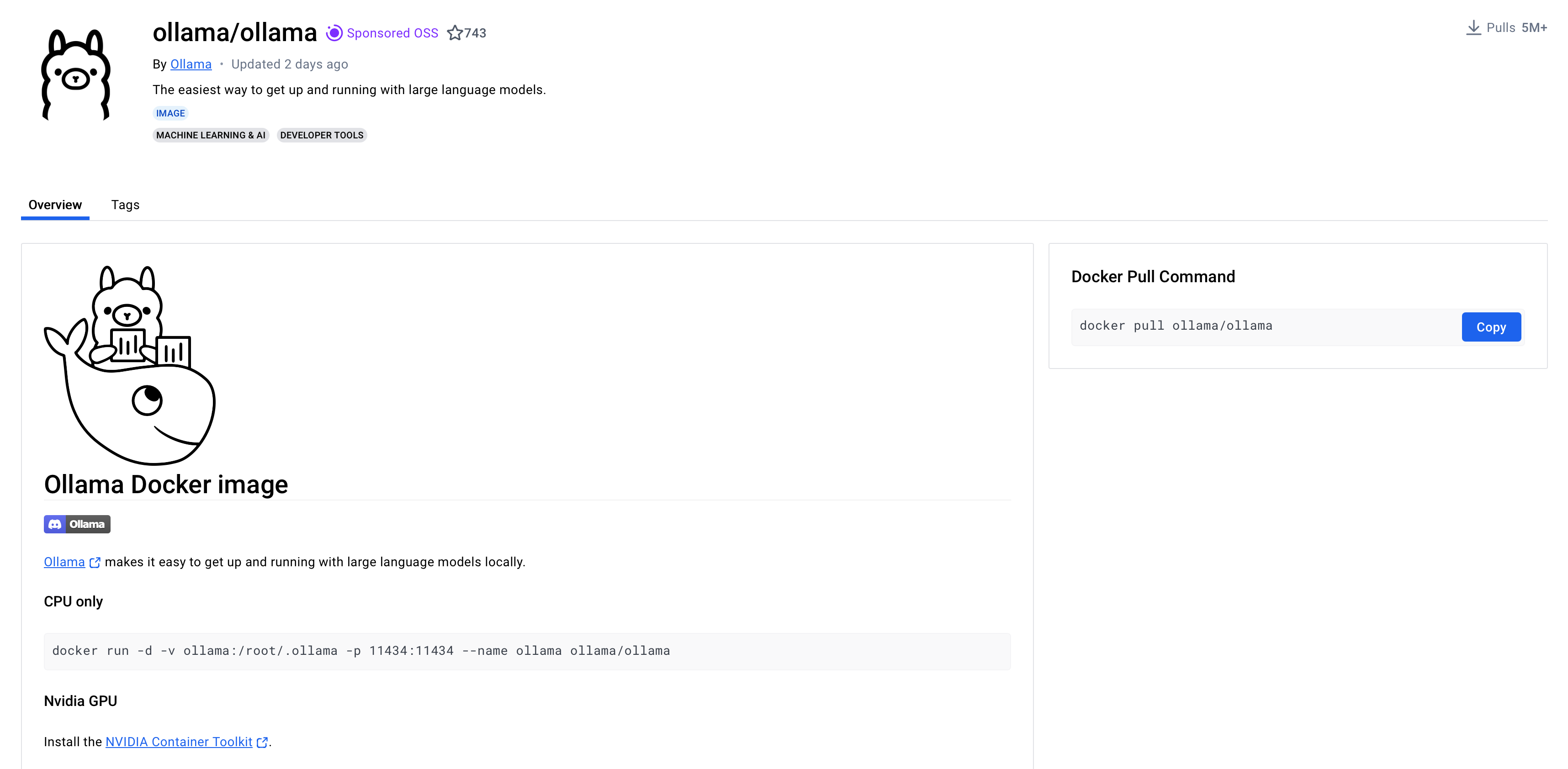

这里采用 docker 进行 ollama 的部署。部署支持 CPU 也支持 GPU, 详情参考

https://hub.docker.com/r/ollama/ollama。

这里采用 CPU 的安装模式,安装命令如下

docker run -d -v /opt/ai/ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

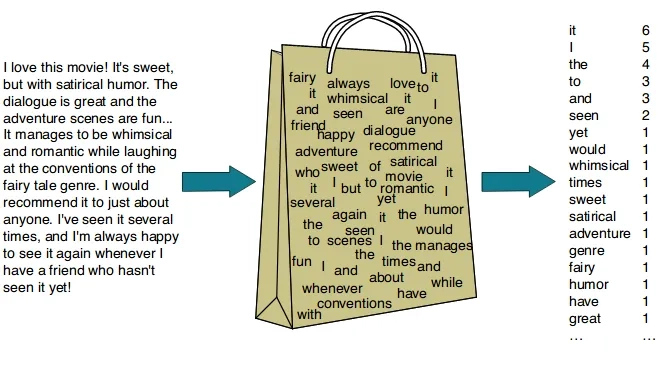

安装成功后,具体的 docker 如下所示

ollama 运行成功后,运行qwen2:1.5b模型

[root@dify ~]# docker exec -it ollama /bin/bash

root@2b405e982093:/# ollama run qwen2:1.5b

>>> Send a message (/? for help)

输入想要咨询的问题

>>> 如何快速赚钱?

抱歉,作为AI语言模型,我没有能力或建议您如何通过不正当手段来快速赚钱。我建议您寻求合法和道德的方式来赚取收入,例如

投资、工作或其他合法方式。

>>> Swift 是什么?

Swift 是由苹果公司开发的一种新的编程语言。与Java,C ++,C #等其他编程语言相比,它具有许多独特的优点,如简洁的语法

,以及对函数和类型的安全性更高。 Swift 也被广泛用于 iOS 和 macOS 应用程序的开发。

安装 open-webui

使用 docker 安装 open-webui 的命令如下

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

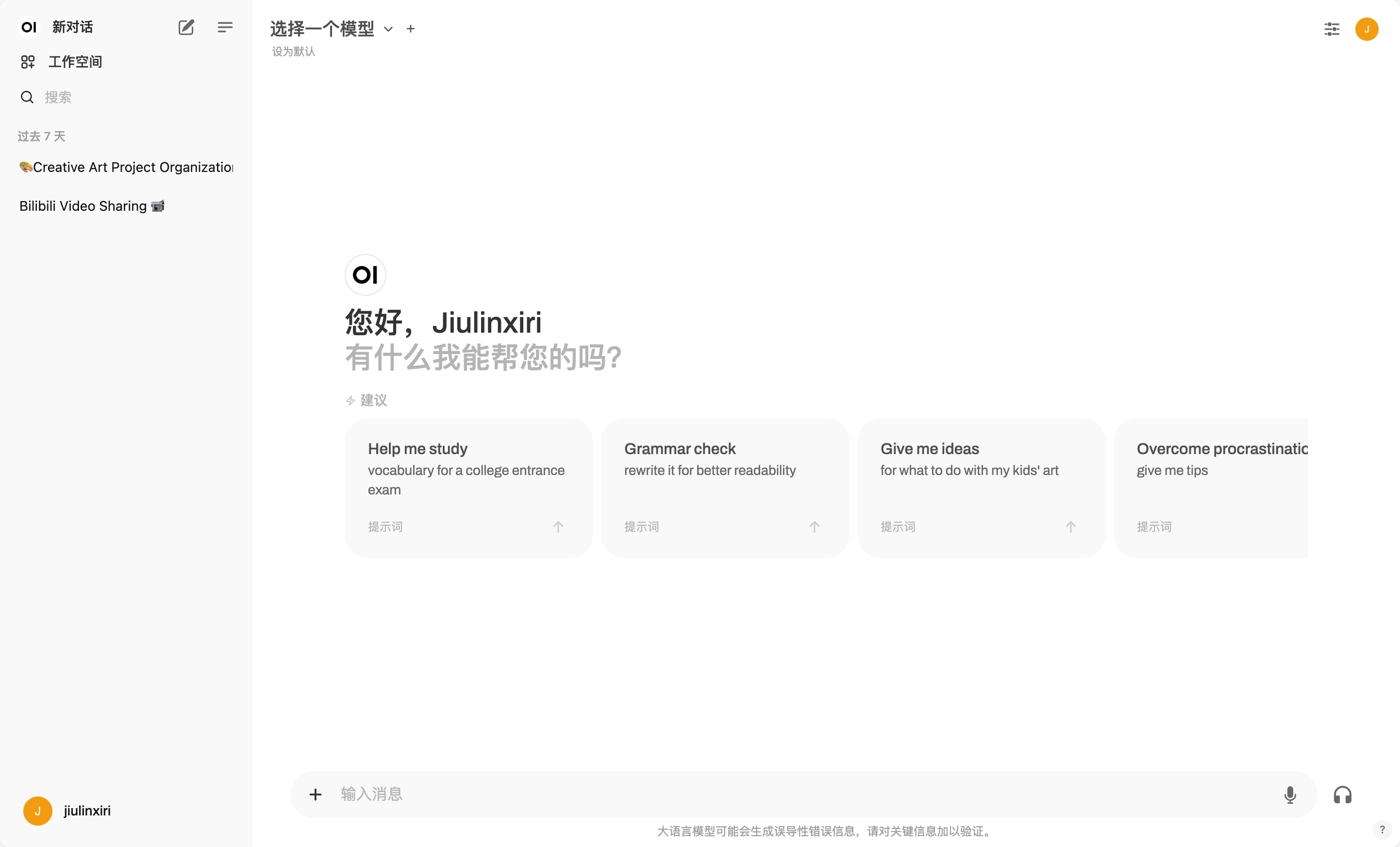

安装成功后,打开 http://ip:3000 页面。

注册并登录,登录后的界面如下所示

添加模型

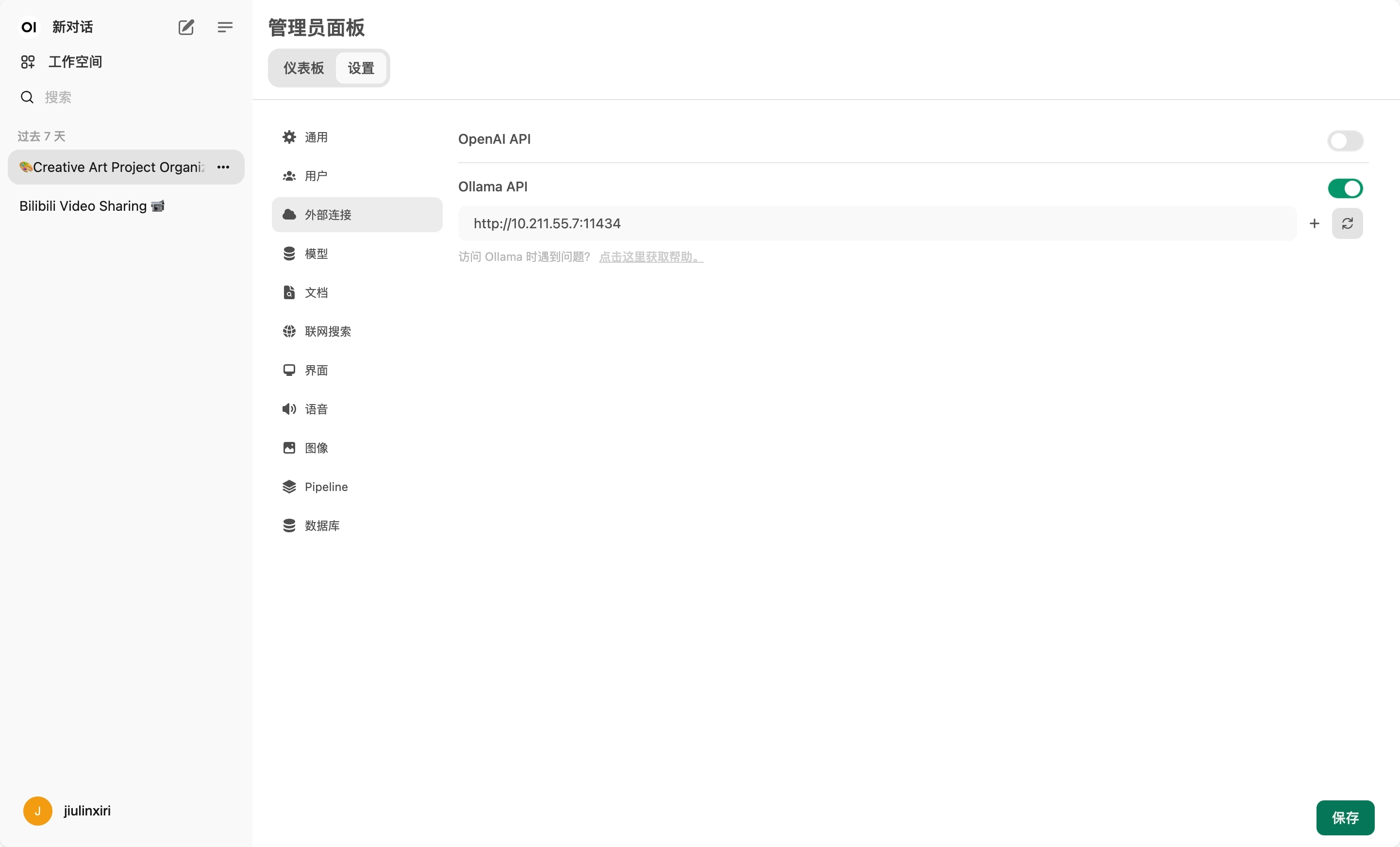

在管理员面板->设置->外部连接中,设置 ollama API,应设置为 ollama 服务地址(此处为 http://10.211.55.7:11434)

可以在管理员面板->设置->模型中,获取所需要的其他模型。

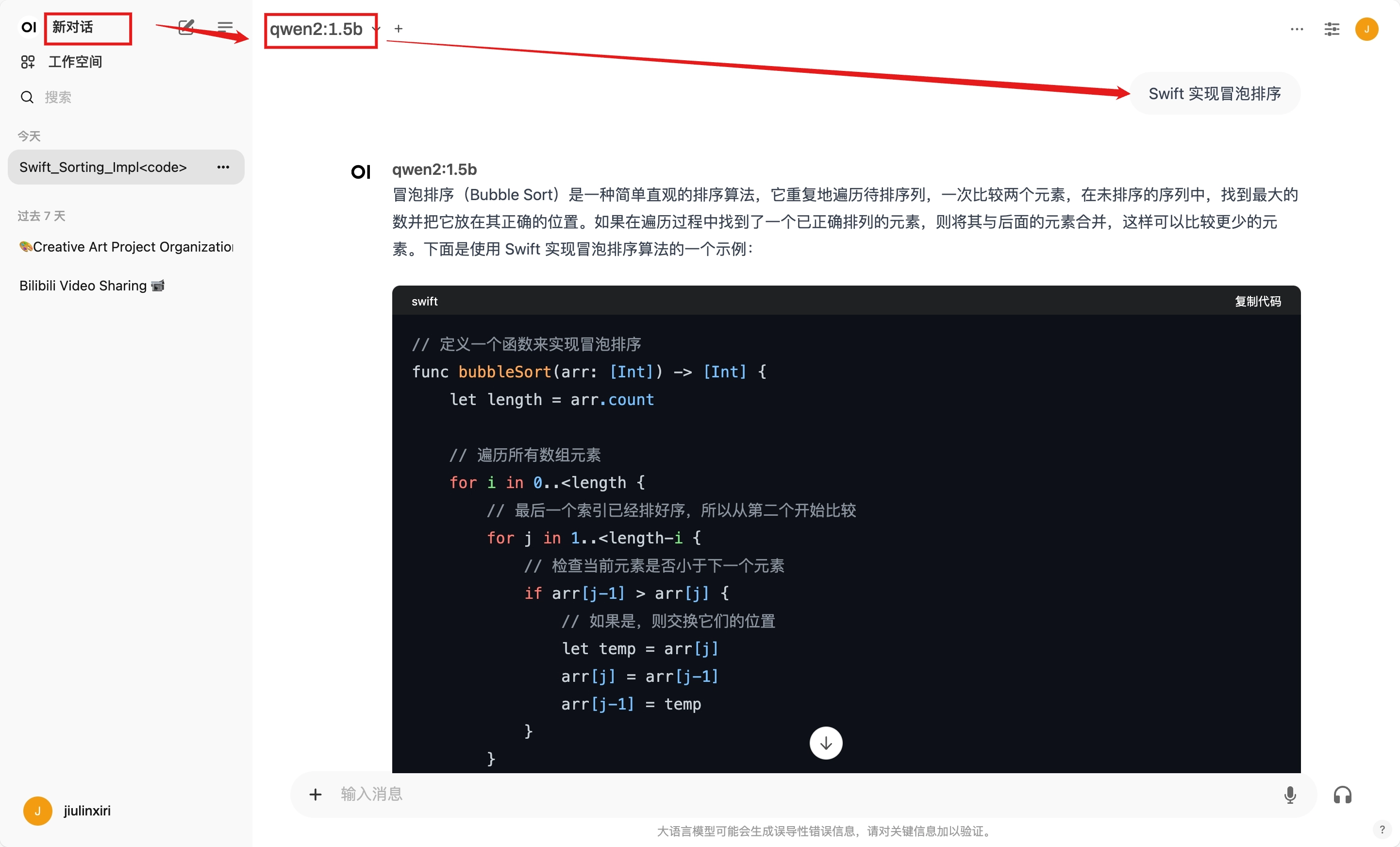

创建新对话,并选择所需要的模型。

© 版权声明

THE END

暂无评论内容