温馨提示:本文最后更新于

2024-11-28 16:45:49,某些文章具有时效性,若有错误或已失效,请在下方留言。下载 Ollama

在 https://ollama.com/download/ 页面下载,系统对应的 Ollama 程序。

![图片[1]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/lCwX9Nm2KFerT7Y.webp)

部署 Ollama

安装 Ollama

双击 Ollama 的程序,即可进行 Ollama 的安装。

修改环境变量

Ollama 的默认模型存储路径如下:C:\Users\%username%\.ollama\models,最好修改模型的安装路径。打开 设置 -> 系统 -> 系统信息 ,点击高级系统设置

![图片[2]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/LkRwy8oWTlZtHjr.webp)

在系统属性中的高级选项卡中,点击 [ 环境变量(N)… ]

![图片[3]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/MZaPgdlDO5TEwFh.webp)

打开「系统环境变量」,新建一个系统变量OLLAMA_MODELS ,然后设置ollama模型的存储路径。

变量名:OLLAMA_MODELS

变量值(路径):D:\Work\ollama\models

![图片[4]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/Q8Y9HXDrakUTenA.webp)

允许浏览器跨域请求(可选)

Ollama 默认只允许来自127.0.0.1和0.0.0.0的跨域请求,如果你计划在其它前端面板中调用 Ollama API,比如Open WebUI,建议放开跨域限制:

变量名:OLLAMA_ORIGINS

变量值:*

![图片[5]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/3JDGitkjm6OEFXT.webp)

对外暴露

变量名:OLLAMA_HOST

变量值:0.0.0.0

![图片[6]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/fIi7WtXLmjPqM4H.webp)

部署模型

在 Ollama 上,可以方便地搜索并下载所需的模型。

搜索模型

访问 https://ollama.com/,在搜索框中输入Qwen后,敲击Enter进行查找,这里选择 qwen2.5 版本模型。

选择模型参数

此处我们选择 7b 参数版本。

![图片[7]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/aZ2eJuxBTYi98MX.webp)

下载模型

在 PowerShell 窗口中,输入以下命令进行模型安装。

ollama run qwen2.5:7b

![图片[8]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/hwpQ15zLxZie2Gu.webp)

使用模型

模型下载完成,可以直接对其进行提问。

![图片[9]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/SdZKum8UVWDxYto.webp)

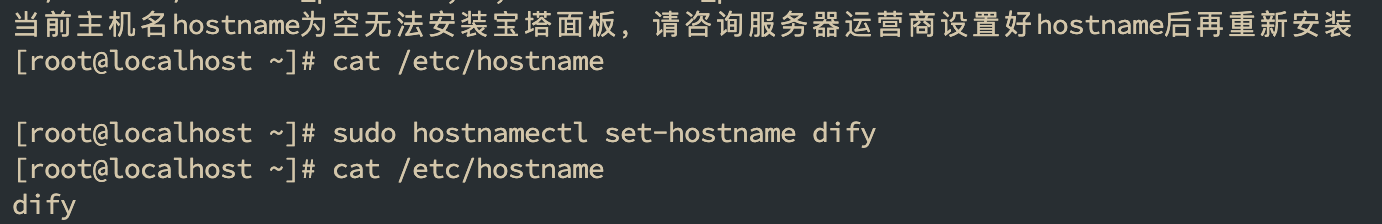

接入 Dify

在模型供应商中,找到 Ollama,按照如下图所示进行填写,然后保存。

![图片[10]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/5Ko16ygkcaSVi7O.webp)

模型名称: qwen2.5:7b

基础 URL:http://192.168.50.237:11434

创建 AI 应用进行调试

![图片[11]-Windows 部署 Ollama-Stewed Noodles 资源](https://cdn.sa.net/2024/11/27/PbNeLDaUSBq8RvE.webp)

© 版权声明

THE END

暂无评论内容